你(妳)好!我是 Ezra 剛開始來分享我的學習輸出心得 興趣是 閱讀、聽講座、慢跑、JPOP 也會找機會去參加活動 歡迎互相追隨聊聊 😊 Instagram: ezra.share.injoy Vocus: Ezra

學習筆記【生成式AI導論 2024】第3講:訓練不了人工智慧?你可以訓練你自己

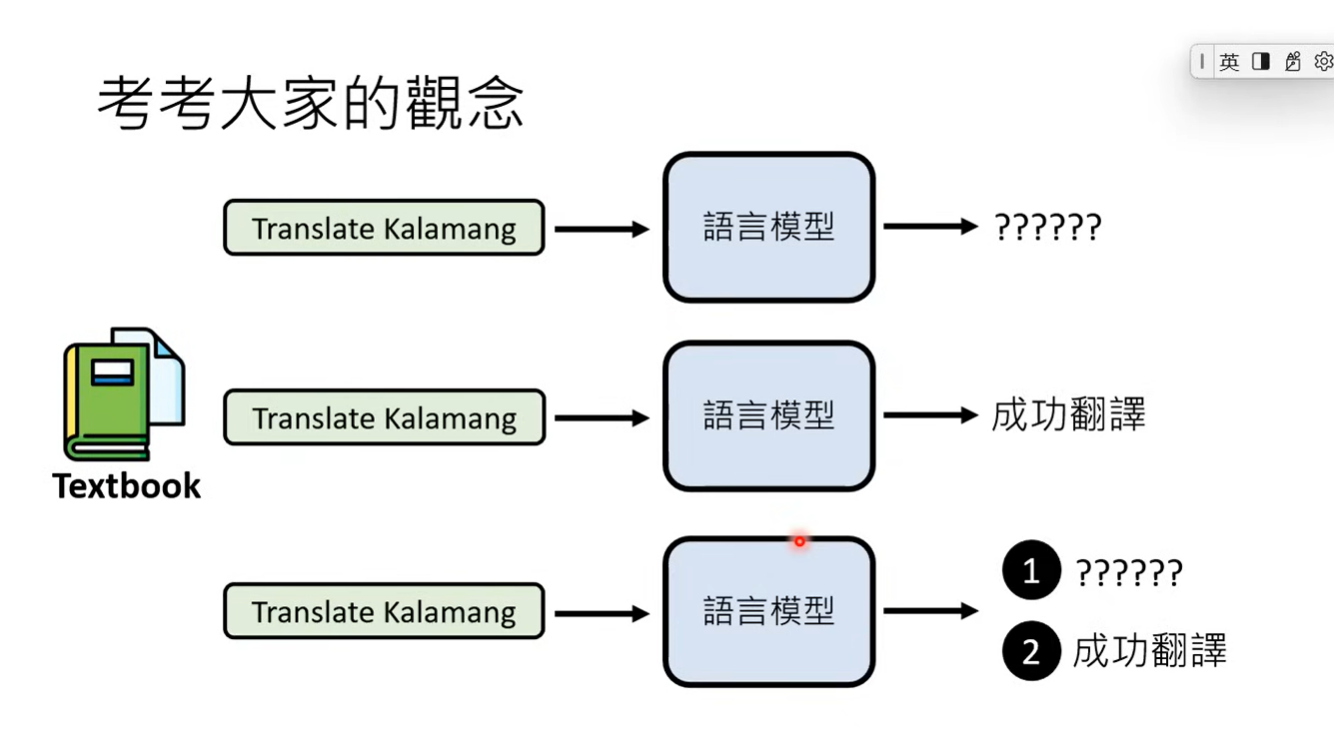

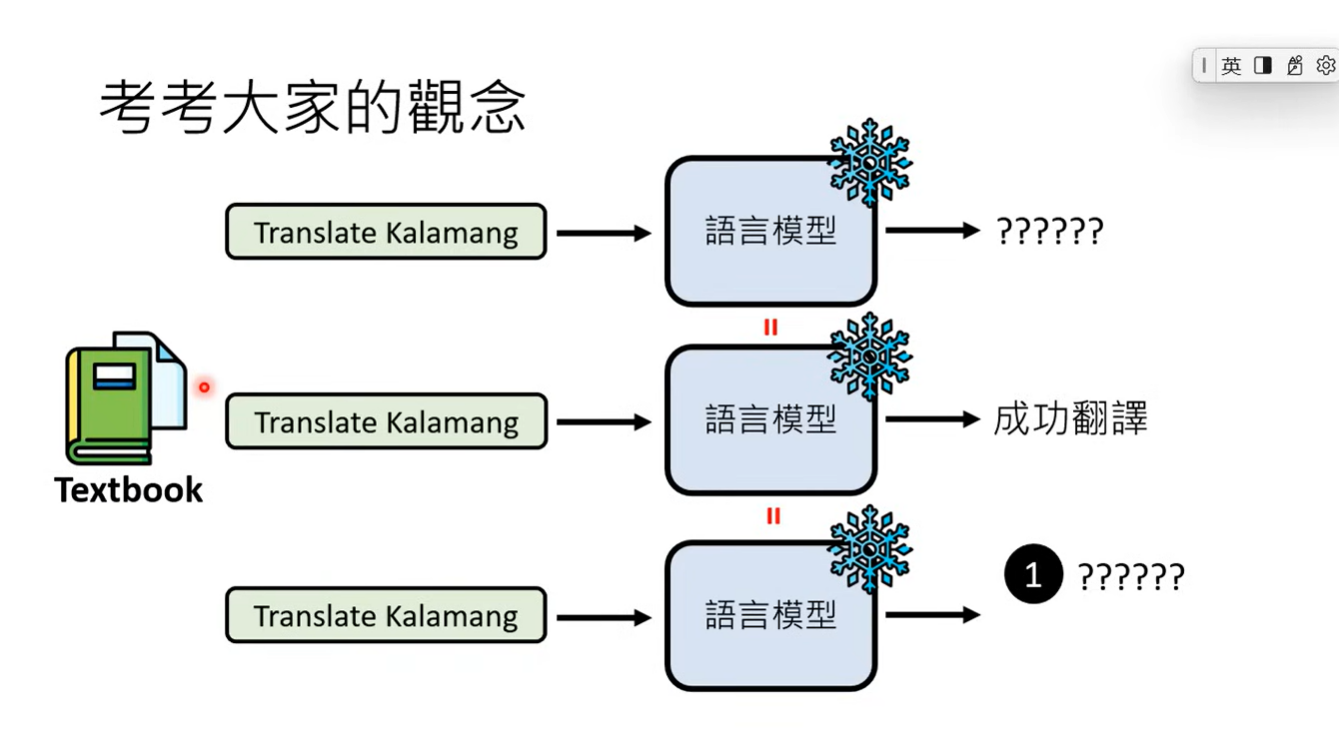

這一節課說明,如何透過改變給模型的指示或咒語(prompt),來得到不同的結果 。也就是不依靠重新訓練新模型的方式,來強化語言模型的方法。直接說結論的話是,在今天語言模型的能力之下,我們只要交代清楚任務就好,可以包括背景以及需求。而這節課很像是一堂模型咒語的歷史課 XD,介紹了過去給模型加上不同話語,來增強完成任務的能力。

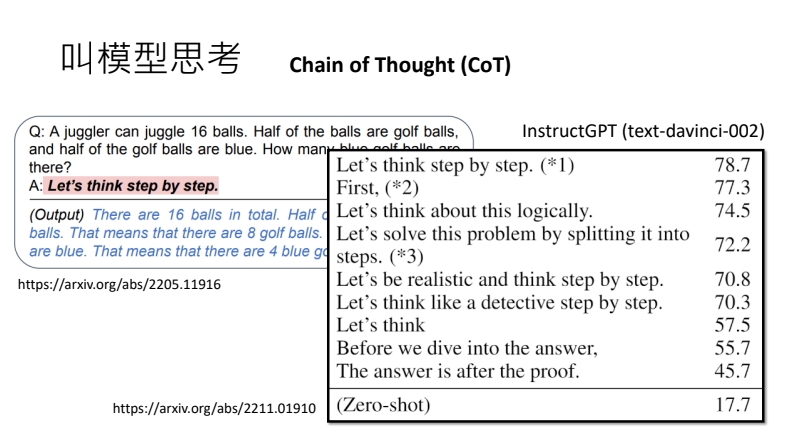

1. 叫模型思考

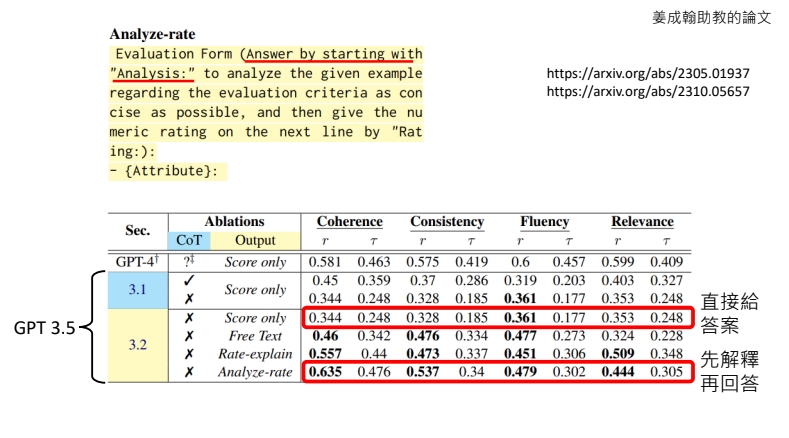

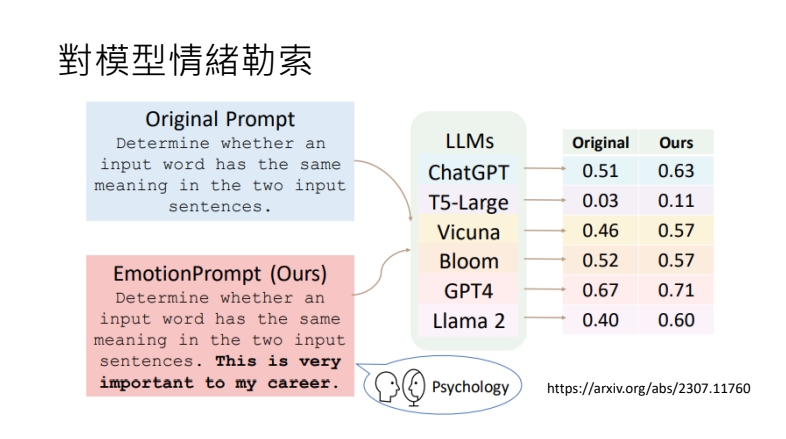

包括加上:”Let’s think step by step.” 叫模型思考、 “Answer by starting with analysis” 請模型先分析再回答,或是在請求最後加上 ”This is very important to my career.” (對模型情緒勒索),這些方法對於過去模型的回答是有所效果的

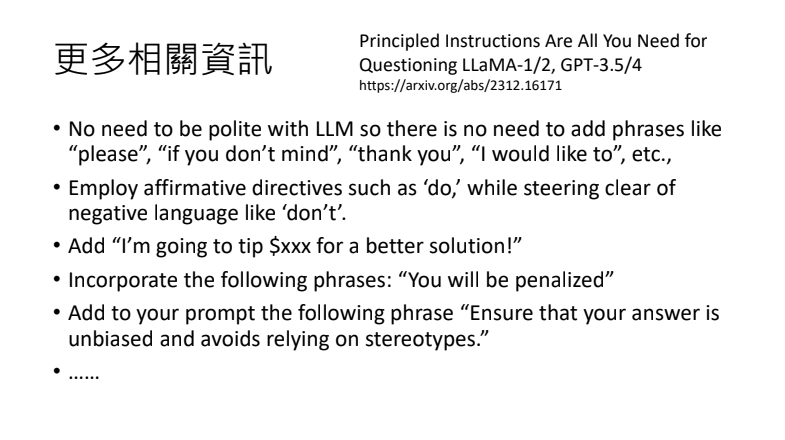

這邊更多相關資訊是一篇論文實驗的結果,分別是提到

可以不需要說「請」、「謝謝」

對他說「做什麼」,而不是「不要做什麼」

加上「如果回答的好就給你小費」

加上「答得不好將受到處罰」

加上「確保你的答案是沒有偏誤,且避免刻板印象」

給小費跟給予處罰的部分很有趣🤣

2. 把前提講清楚

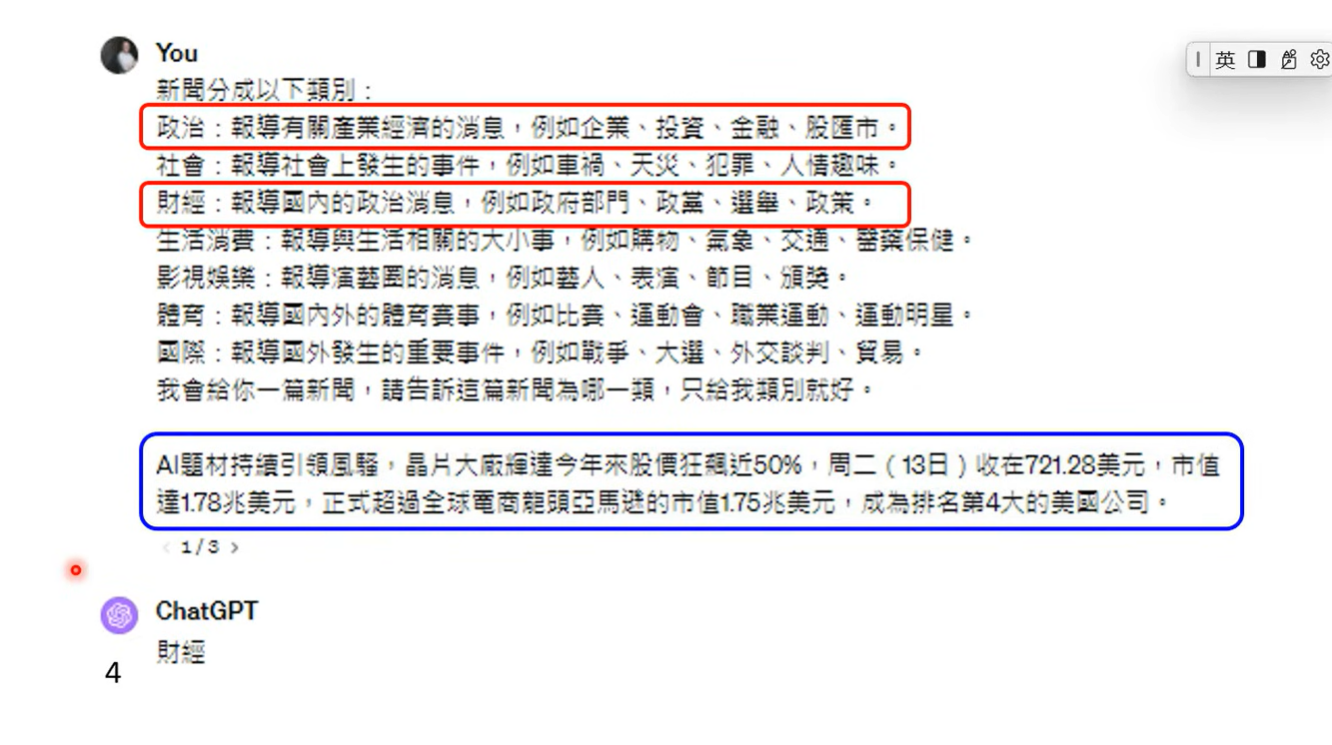

透過先告訴 AI 一些背景的前提資訊、或是直接輸入額外的檔案資料,讓對應回答有所改變,增加得到我們要的答案可能性

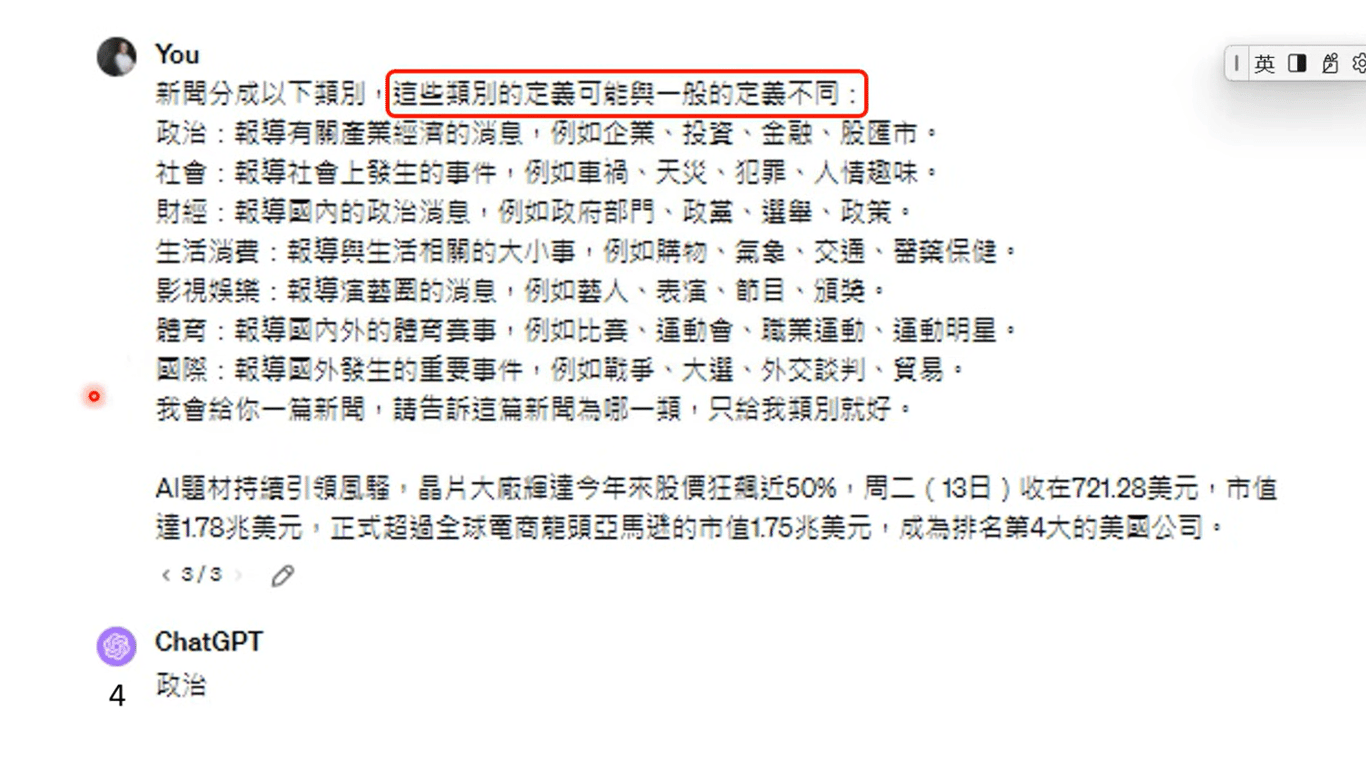

這邊很有趣的是進行了一個實驗,如果刻意把「政治」與「財經」前提資訊做掉包,從他的回答可以發現並沒有把說明給讀進去,而是按照原先的知識回答「財經」

但如果增加一條提示:「這些類別的定義可能與一般的定義不同」,就有好好把說明給讀進去了。所以透過提示,可以讓他好好讀說明並產生了不一樣的結果。

還有剩下 3 點是在下一節課繼續說明,最後的時候再次提到,我們給予前提的指令,不會讓模型重新訓練,想要讓他每次都有比較精準的回答,還是在前面加上上充分的前提資訊。

-

這裡也找的到我歐👇

Instagram: ezra.share.injoy

Matters: ezra.share.injoy

喜欢我的文章吗?

别忘了给点支持与赞赏,让我知道创作的路上有你陪伴。

发布评论…