太陽盛德導師、蜜之歌、福到你家、愛、感恩

用Python去抓露天一整頁手機收購的項目名稱

用Python去抓露天一整頁手機收購的項目名稱

按照上一篇文章累積的經驗,自行改了一下網址的部分

然後我開原始碼去找的div的特性

titles=root.find_all("div", class_="item-info")

改成像上面這一行這般,先放上我整個py檔案的程式碼給大家參考

----------------#以下是crawler.py的程式碼------------------

#抓取Ptt電影版網頁原始碼

import urllib.request as req

#建立一個request物件,附加Request Headers資訊

request=req.Request(url, headers={

"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.87 Safari/537.36"

})

with req.urlopen(request) as response:

data=response.read().decode("utf-8")

#print(data)

#解析原始碼,取得每篇文章的標題

import bs4

root=bs4.BeautifulSoup(data, "html.parser")

#讓BeautifulSoup協助我們解析html 找出我們想要的部分

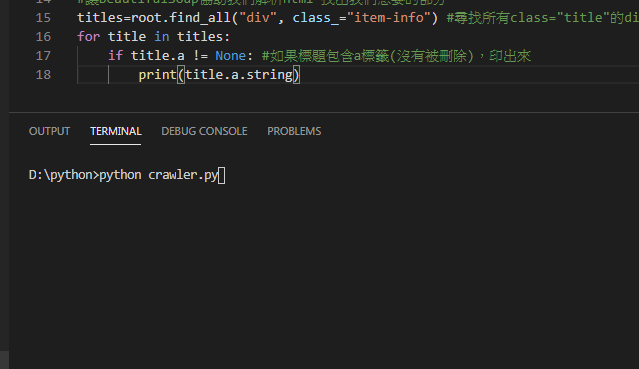

titles=root.find_all("div", class_="item-info") #尋找所有class="title"的div標籤

for title in titles:

if title.a != None: #如果標題包含a標籤(沒有被刪除),印出來

print(title.a.string)

----------------#以上是crawler.py的程式碼------------------

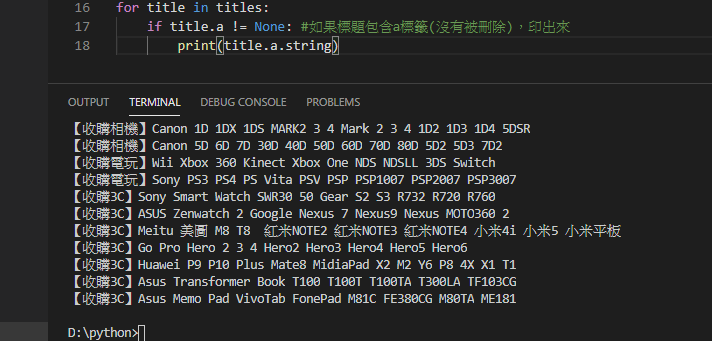

存檔,跑來玩玩

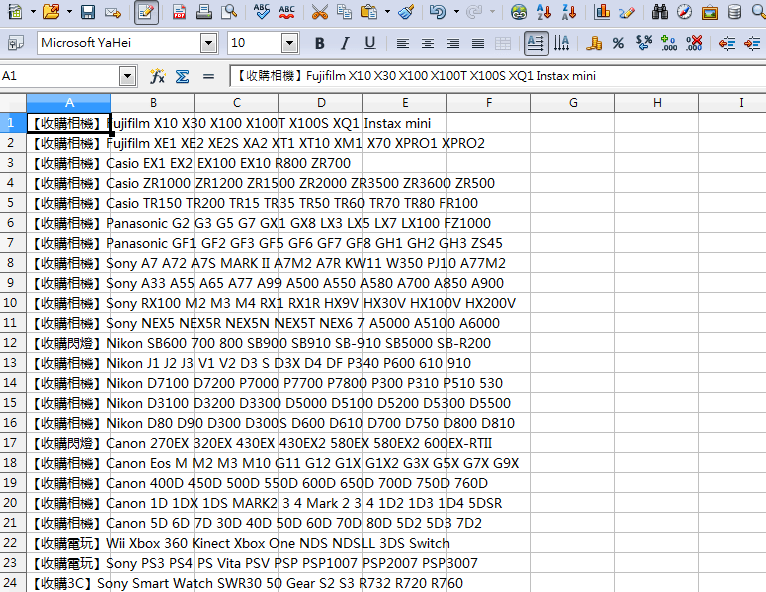

把結果通通複製起來,貼到自己的Excel上面去做加工處理

爬完收工

喜欢我的文章吗?

别忘了给点支持与赞赏,让我知道创作的路上有你陪伴。

发布评论…