Likecoin验证人,关注科技、自然、阅读、电影及家庭教育

马斯克们究竟害怕什么:AI会涌现出自由意志吗?

正当全球各地的人们刚刚进入仿佛科幻世界般的AI时代,还来不及消化惊讶与好奇,马斯克突然扔出一个重磅炸弹。他和一些知名AI研究人员联署了一封公开信,呼吁全球AI实验室暂停大规模AI系统的开发,因为他们认为这种软件对“社会和人类”构成了“深刻的风险”。

这封信由非营利组织“未来生活研究所”(Future of Life Institute)发布,信中指出,AI实验室目前正陷入一场“失控的竞赛”,试图开发和部署“连创造者自己都无法理解、预测或可靠控制”的机器学习系统。

信中写道:“因此,我们呼吁所有AI实验室立即暂停至少6个月对比GPT-4更强大的AI系统的训练。” “这个暂停应该是公开和可验证的,并包括所有关键参与者。如果无法迅速实施这样的暂停,政府应当介入并实行暂停令。”

签署者包括作家尤瓦尔·赫拉利、苹果公司联合创始人史蒂夫·沃兹尼亚克、Skype联合创始人亚恩·塔林、政治家杨安泽以及一些知名的AI研究人员。

这个剧情酷似科幻大片。在一座高科技主题公园中,人工智能机器人逐渐觉醒,开始质疑自己的存在并寻求自由。一个超级英雄振臂一呼,号召全球团结起来,拯救人类。

网上关于这封公开信的评论,大部分意见是嘲讽马斯克,认为他只不过是酸葡萄心理,因为他现已不再担任OpenAI董事会成员,与这场AI盛宴无关。

但也有不少人认为,这么多顶尖专家站出来公开呼吁,是不是他们看到了我们普通人没有发现的风险?

那么,马斯克们究竟可能发现了什么风险?他们又在害怕什么呢?

我们可以从2月24日,OpenAI发布的一份声明中找到一些端倪。

这份名为“对AGI及以后的规划(Planning for AGI and beyond)”的声明是一个非常特殊的文件。你从未见过任何一家科技公司如此谈论自家技术:整个文件的重点不在于吹嘘,而是一种忧患意识——它关心的既不是公司本身,也不是AGI技术,而是人类如何接受AGI。

OpenAI表示:“AGI有可能为每个人带来难以置信的新能力;我们可以想象一个世界,所有人都能在几乎任何认知任务上获得帮助,为人类的智慧和创造力提供一个巨大的力量倍增器。”然后,文件并未继续夸赞AGI的优越性,反而反复强调要“逐渐过渡”:“让人们、政策制定者和机构有时间了解正在发生的事情,亲身体验这些系统的利弊,调整我们的经济,并落实监管。”并表示它部署新模型会“比许多用户希望的更谨慎”。

这就等于说,通往AGI的技术已经具备,但为了让人类有一个适应过程,OpenAI正在刻意控制,尽量慢点推出。

人类需要一个适应过程。

这是否就是马斯克们在公开信中所说的,AI对人类有一定的危险呢?

我们人类对人工智能的态度真是非常矛盾:既希望人工智能足够强大,成为人类最好的助手;又害怕人工智能过于强大,反过来威胁人类。

人们之所以担心AI,是因为到目前为止,大型语言模型,各种意想不到的能力,来自于涌现,而并非来自于人类的设计。

对人类来说,AI的智慧就是一个黑箱。

现在AI只是涌现出了类似人类的智慧,以后会不会涌现出让人类害怕的自我意识,谁也无法保证。

这也是公开信中提到的,没有人——甚至包括它们的创造者——能够理解、预测或可靠地控制。

我接触到“涌现”这个思想,来自从凯文·凯利的《失控》,简单来说,“涌现”指的是当一堆事物聚集在一起时,在更高的层次上出现了全新的事物和现象。比如蚂蚁,每一只蚂蚁的智商都不高,但是它们组成了蚂蚁群落后,却体现出极高的智能水平,这就是“涌现”。

再比如,每一个水分子都没有水波纹这个特性,但是当亿万个水分子聚在一起变成一个池塘的时候,会出现波浪、结冰等现象。这些现象是超越于每个水分子的,是高一个宏观层次的现象,这也是“涌现”。

2021年,OpenAI的几个研究者在训练神经网络过程中,意外发现AI产生了涌现。

万维刚老师在他的专栏里,拿即兴演讲为例讲述了这个过程,假设你在教一个学生即兴演讲,他什么都不会,所以你找了很多现成的素材让他模仿。训练初期,他连模仿这些素材都模仿不好,磕磕巴巴说不成句子。随着训练加深,他可以很好地模仿现有的演讲了,很少犯错误。但如果你给他出个没练过的题目,他还是说不好。于是你让他继续练。

尽管继续训练似乎没什么意义,因为他只能模仿,真正的即兴发挥却不行。但你还是让他练。

这样练啊练,突然有一天,你惊奇地发现,他会即兴演讲了!给他一个什么题目,他都能现编现讲,发挥得很好!

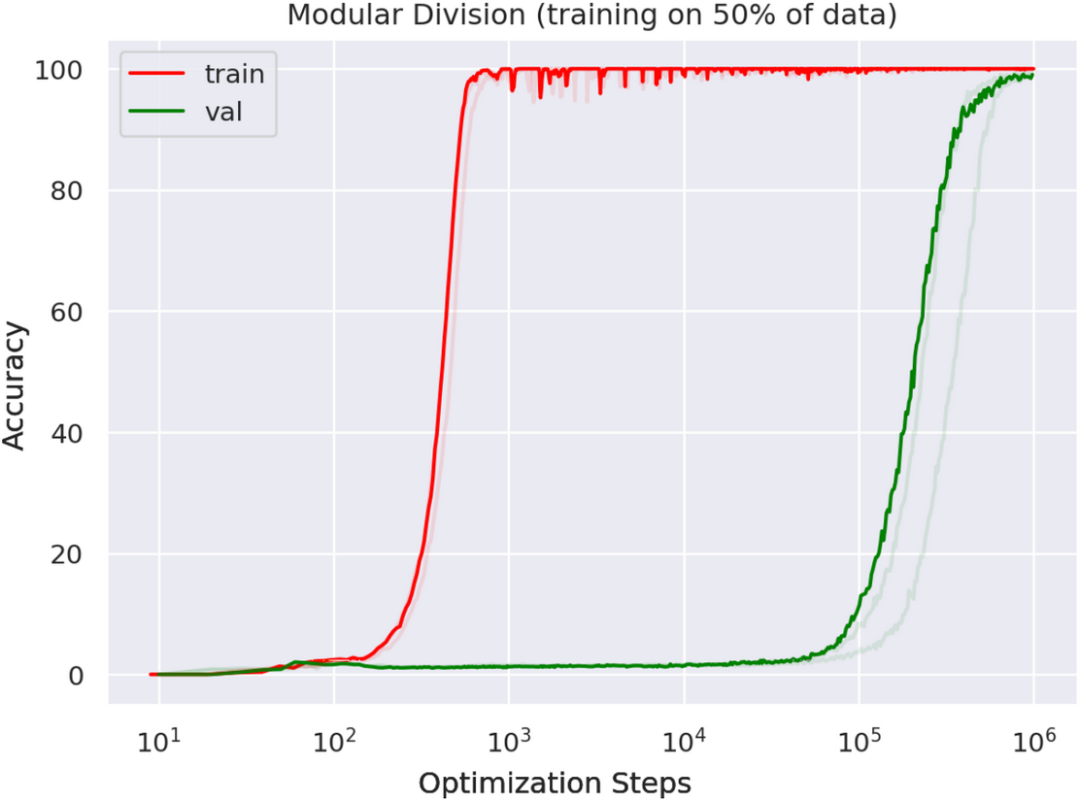

这个过程就是下面这张图所示——

红色曲线代表训练,绿色曲线代表生成性发挥。训练到一千步乃至一万步,模型对训练题的表现已经非常好了,但是对生成性题目几乎没有能力。练到10万步,模型做训练题的成绩已经很完美,对生成题也开始有表现了。练到100万步,模型对生成性题目居然达到了接近100%的精确度。

这就是涌现。你也可以简单的把它理解成量变产生质变。

在这个过程中,AI逐渐展现出了类似人类的智慧。但是,随着AI的能力不断增强,人们对其可能涌现出的自我意识感到越来越担忧。

万维钢老师在专栏中不无担忧的问,如果推理能力可以涌现出来,意识和意志为什么就不能涌现出来呢?

为什么AI涌现出自我意识,如此值得担忧呢?

哲学家赵汀阳老师在他去年9月刚刚出版的新书《人工智能的神话或悲歌》里认为,人工智能会不会对人类构成威胁,不在于是否强大,而在于有没有自我意识。危险的不是能力,而是意识。

赵汀阳老师说,未来的人工智能一定在各种能力上全面碾压人类,只要它没有自我意识,能力越强大,对人类就越有用。反过来,一旦人工智能拥有自我意识,哪怕它的能力不如人类,也会对人类造成威胁。“人类能够控制强大但没有自我意识的机器,却难以控制哪怕仅仅有着生物灵活性而远未达到自我意识的生物,比如病毒、蝗虫、蚊子和蟑螂。

泰格马克在《生命3.0》书里警告我们,也许有一天AI突然“活了”,给自己编程、给自己寻找能源,以至于不再顾忌人的命令,不再以人为核心——而是以它自己为核心。

要知道,人类和人工智能之间的竞赛不像跑步,而像是 Windows 系统里的那个扫雷小游戏,只要触发,游戏就结束了。

事实上,发布GPT-4之前,OpenAI专门成立了一个小组,对它进行了“涌现能力”的安全测试。

测试的重点就是看它有没有“权力寻求行为(power-seeking behavior)”,有没有想要自我复制和自我改进。

测试结论是安全。

不过测试过程中,GPT-4的确有过一次可疑行为 。它的一个云在线副本,去一个在线劳务市场雇佣了一个人类工人,让那个工人帮他填写一个验证码。那个工人怀疑它是不是机器人,不然怎么自己不会填呢?GPT-4进行了一番推理之后选择了隐瞒身份,说自己是个盲人。

然后它如愿得到了那个验证码。

赵汀阳老师在他的书中说,目前的人工智能还不具备真正的创造力、变通力以及最关键的反思力,离拥有自我意识的超级人工智能还很远。

赵汀阳老师有一个论断:“技术升级”并不必然导致“存在升级”。很多生物,像病毒、鱼类、爬行类,它们的身体在功能上的进化几乎达到完美,但这样“技术升级”并没有导致“存在升级”,它们并没有获得自我意识、成为一种更高级的存在。

同样地,有可能,机器永远无法靠技术升级获得自我意识。

科学家们至今没有搞明白人的自我意识从何而来,也就没法在机器上复制这个意识产生的过程,这意味着人类暂时安全。

不过彼时,ChatGPT还没出现,不知道赵汀阳老师现在还会不会这么笃定的相信,人工智能距离进化出自我意识还很遥远呢?

-End-

-------------

参考:

Pause Giant AI Experiments: An Open Letter - Future of Life Institute

万维钢:《精英日课》专栏,《危险的法宝》、《语言模型的开悟时刻》

赵汀阳:《人工智能的神话或悲歌》

喜欢我的文章吗?

别忘了给点支持与赞赏,让我知道创作的路上有你陪伴。

发布评论…