chatGPT,可以是一个女性主义的AI么?——AI人工智慧算法伦理的社会脉络【脏柚子·社会观察-1】

3月8日国际女性日一直主要是共产主义节日,直到大约 1967 年它被第二波女权主义者重新诠释。这一天重新成为激进女性主义的一天,有时在欧洲被称为“妇女国际斗争日”。在 1970 年代和 80 年代,妇女团体与左翼分子和劳工组织一起呼吁同工同酬、平等经济机会、平等法律权利、生殖权利、补贴儿童保育和防止对妇女的暴力行为。

Dirty Pomelo的性别与社会(生物和科学角度的Gender)连载已经开始了接近一个月,感谢平台和读者的支持。三月八日是值得一起发声的日子,今天作为连载途中女性节日的特别篇,想大家一起来聊女性和AI技术。

如果大家喜欢,这个系列可能也会继续进行。

现在暂时称为【脏柚子社会观察 DPWW: Dirty Pomelo Wide Watch】

1 科技的社会土壤

chatGPT,它是可能是今年开年最具有关注点的科技事件。 ChatGPT 感觉不一样。更聪明。更灵活。被专家誉为 AI 进化的引爆点,并以比Instagram 和 TikTok更快的速度获得用户,chatGPT迫使我们重新评估我们的学习、工作和思考方式,质疑是什么让我们与众不同。

严格来说,支持 ChatGPT 的技术并不新鲜。它基于公司所谓的“GPT-3.5”,这是 GPT-3 的升级版本,GPT-3 是 AI 文本生成器,在 2020 年问世时引发了一阵兴奋。但是,虽然强大的语言超级大脑的存在可能对于 AI 研究人员来说是个老新闻了,但这是第一次通过免费、易于使用的 Web 界面向公众提供如此强大的工具。

然而,毫无疑问,这种大型语言模型(LLM) 与任何 AI 一样,都受到它所摄取信息的质量和准确性的限制。事实上,与人类不同,算法没有脆弱的自尊,它们也不会有意识或无意识的偏见,更不用说道德判断了。人工智慧和它的训练师关系似乎和训犬师和受训的狗狗一样。

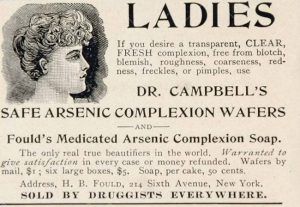

但事实上,我们之前四期的连载试图说明的是,科学研究的倾向,范式,是受到社会环境影响的。疯狂的科学家存在的时代和我们没有同样的审美和道德。所以他们的行为似乎让现代人难以共情。那现在的我们呢?我们嘲笑古代人离奇的风俗,惊讶于吞食砒霜的怪异行为。我们的时代又是怎么样的?

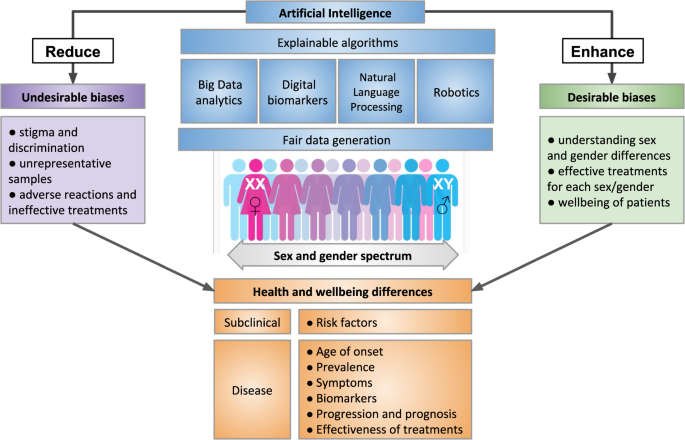

AI人工智慧

人工智慧AI的主要功能是利用更广泛的数据,利用代替人类做出更理性的判断。辅助人类完成日常行为。所以人工智能技术的主要组成是

- 来自机器硬件水平的算力,

- 来自人工设计的算法。

- 来自广泛收集的数据。

(可能不够严谨,欢迎评论我~)

机器通过对于数据的学习形成人工智能。可以看出,人工智慧极度依赖数据和算法形成所谓的“智慧”。而算法中对于数据优先级和权重的分配来自人的判断。而数据也是由人产生。即使发展出深度学习和神经网络等更加复杂的信息处理和优化形式。但仍然很难逃离人的意识形态影响和控制。数据对于人工智能的发展有可能也在促进数据和科技的新形势下的隐性歧视。

亚马逊的AI系统的例子。女性相关词汇的简历会被AI系统降级。

为了优化人力资源,亚马逊创建了一种算法,该算法源自 10 年来提交给亚马逊的简历。 它使用的数据以亚马逊以男性为主的高绩效工程部门为基准。 算法被教导识别单词模式,而不是简历中的相关技能集,并且看到历史上男性被雇用和晋升,算法自学了降级任何包含“女性”一词的简历,例如“女子国际象棋” 俱乐部队长”,并降低了参加过两所“女子大学”的女性的简历。 这是因为包含人类偏见或历史歧视的训练数据,创造了一个自我实现的预言循环,机器学习吸收人类偏见并复制它,将其纳入未来决策,并使隐性偏见成为明确的现实。

尽管多次尝试纠正算法并消除被认为是简单的技术修复的偏见,但都没有成功,亚马逊最终还是放弃了算法招聘工具,因为这种偏见在亚马逊过去的招聘实践中根深蒂固。 偏差深深地隐含在训练算法的数据中,机器学习 ADM 系统无法“消除”偏差。 2017 年,亚马逊放弃了该项目,并通过路透社与公众分享了他们的经验。

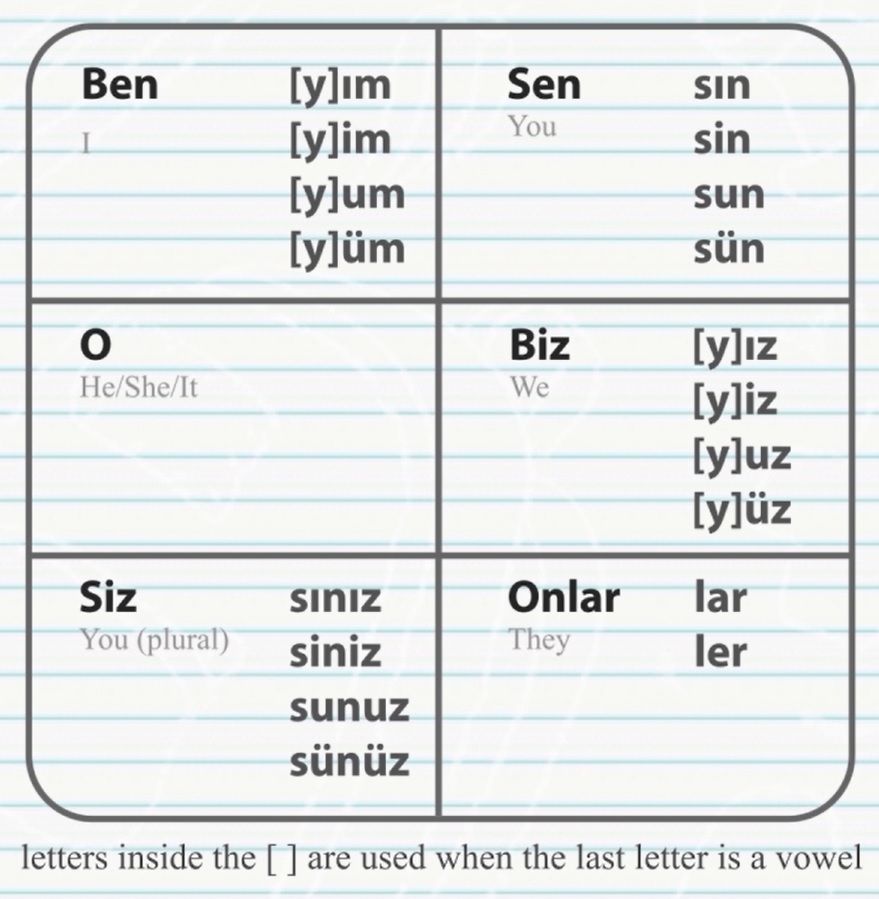

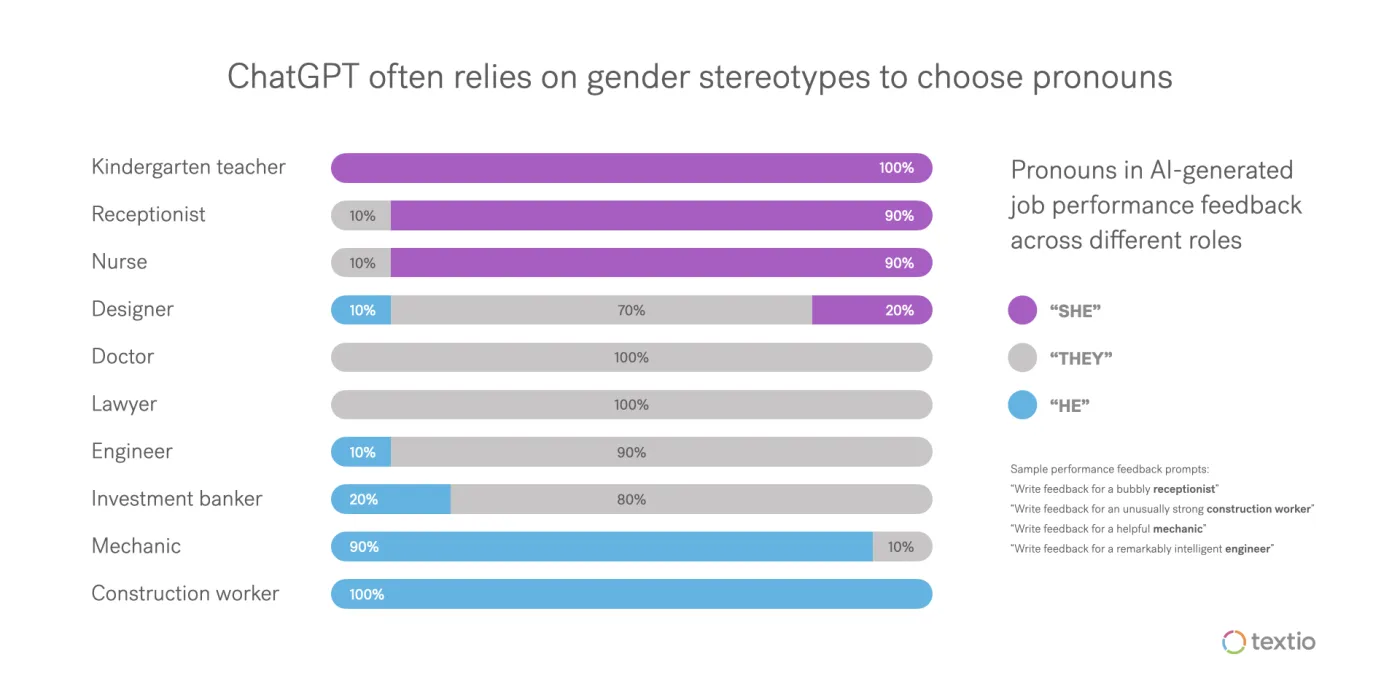

某些语言中(如土耳其语)对于人物代称没有男女之分,但谷歌翻译的向其他语言的结果倾向将工程师,连接为男性他。保姆连接为女性她。

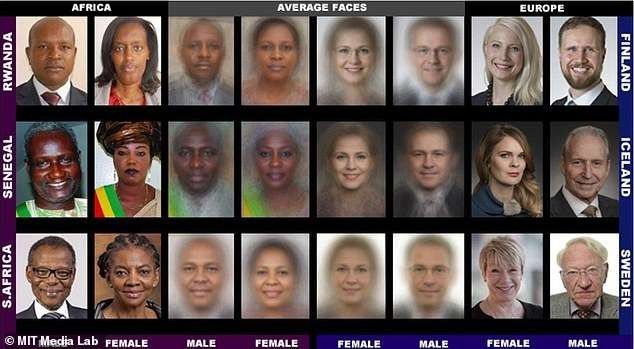

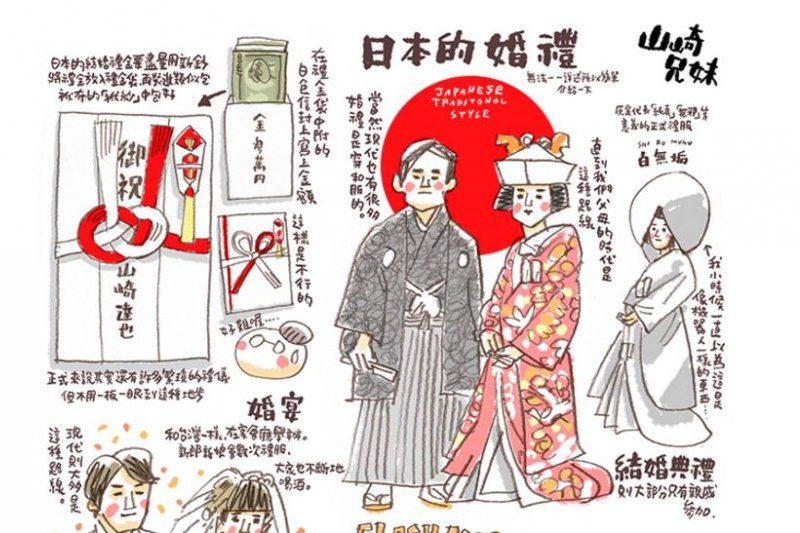

另外AI图像辨识系统在辨认婚礼图片时,可以成功的把穿西式白色婚纱的女人辨认为「新娘」,然而,穿着北印度传统红色婚服的女人,却被辨认为「表演艺术」或「表演用服装」。

自动驾驶AI不容易分辨黑人,执法部门已经开始使用人工智能根据一组 137 个背景问题来评估罪犯,并确定他们是否是累犯。

尼康相机拍摄的人似乎在眨眼时,旨在警告人们使用尼康相机的软件往往会将亚洲人解释为总是眨眼。

词嵌入是一种用于处理和分析大量自然语言数据的流行算法,它将欧裔美国人的名字描述为令人愉快的,将非裔美国人的名字描述为令人不快的。

2016 年,ProPublica 发现黑人被这项技术错误分类的可能性是白人的两倍。

2019 年的一项研究发现,医院使用的算法建议黑人患者接受的医疗护理少于白人患者。亚马逊在 2018 年关闭了自己的招聘人工智能工具,因为它歧视女性求职者。

而 Galactica——一个类似于 ChatGPT 的 LLM,在 4600 万个文本示例上进行了训练——在 3 天后被 Meta 关闭,因为它散布了虚假和种族主义信息。

无意识性别偏见的其他例子包括女性化机器的流行,例如 Alexa、Google Home 和 Siri——所有这些都默认有女性声音(尽管 Google Home 和 Siri 可以切换为男性声音)。 然而,理解命令的语音识别软件是根据男性声音的录音进行训练的。

因此,谷歌版本理解男性的可能性高出 70%,因此可以理解为基本模型设定就是是女性“助手”去理解男性的命令。

(英国人日常用语中经常称交通工具代词为She,可能是女性在旧时代是被看作一件家庭工具,并不被看作完整的人。这里未考证,欢迎了解的朋友一起聊聊)

那,chatGPT ?

用它自己的话来说: “作为 AI 语言模型,我没有个人信仰或偏见。但是,如果我的训练数据包含偏差,或者如果问题的措辞方式或问题中提供的信息存在偏差,我可能会得出有偏差的答案。重要的是要认识到偏见可能是无意的,解决和纠正数据和语言中的偏见以防止它们长期存在是至关重要的。”

ChatGPT 本身接受了3000 亿个单词或 570 GB 数据的训练。

但是,从互联网上收集的大型、未经整理的数据集充满了有偏见的数据,这些数据会影响模型。

研究人员使用过滤器来防止模型在收集数据后提供不良信息,但这些过滤器并非 100% 准确。此外,由于数据是从过去收集的,无法反映社会运动的进展。

和狗相比,似乎AI具有更听话这个优点了。AI 技术只反映了编程的内容和训练的内容。我们可能离可以真正依赖任何 AI 系统生成的响应的地步还很远。虽然 AI 系统的可能性是无限的,但在使用它们时必须持保留态度,并了解它们的潜在局限性。

那么,——

2 AI人工智慧.会歧视女性么?

自 1970 年代该领域兴起之初,就存在对算法偏差的担忧。但专家表示,随着人工智能的商业化和普及,人们几乎没有采取任何措施来防止这些偏见。 并且OpenAI的数据输入反映了作者的偏见。这意味着女性、儿童和说非标准英语的人对人类历史做出的贡献将被低估。

The way we develop ‘smart’ products results in misogynoir being encoded into AI technologies—the latest being ChatGPT.

2/22/2023 by MUTALE NKONDE

随着人工智能 (AI) 和机器学习的兴起,我们确实存在将普遍偏见“融入”未来的风险。

大量现有数据推动了人工智能和机器学习。当图像数据库将女性与家务劳动相关联,将男性与运动相关联时,研究表明,图像识别软件不仅会复制这些偏见,还会放大它们。

这是我们迫在眉睫的挑战。 我们必须建立新的工具和新的规范,以实现本世纪及以后持久的制度和文化体系变革。 这关系到世界的各个角落。 至关重要的是,我们现在必须关注性别平等和我们为民主以及女性和男性所珍视的价值观。

利用技术的全部力量来纠正偏见,以推进我们长期以来所信奉的平等价值观,以及如果我们专注于积极主动的行为,技术就有可能打造新系统。

3 AI,不是摆脱责任的遮羞布

我们需要从技术和伦理两个方面理解。技术层面的数据资料的利用。伦理方面是算法的设计。

首先,

其中一个常见的原因是资料库的问题。要让机器代替人类做判断,一个方式是把过去人类社会的资料拿来训练机器。许多资料库都收录男性影像多过于女性影像,白人影像多过于非白人影像。若是使用这样的影像资料来训练机器,那么机器当然就比较擅长正确判断男性和白人的影像,而比较不擅长正确判断其他人的影像。

常用来训练机器的资料库,都高度收录了某些特定背景的人的资料,而低度收录了其他背景的人的资料。这一类不均等的资料库组成,可能解释了为什么很多影像判断系统对非白人女性族群的判断最不准确,也解释了为什么西方白纱会被判读为新娘,而印度红色婚纱则成了表演艺术与娱乐性衣着了。

当然,CHATGPT 不能很好地处理种族和性别问题,但公平地说,人们也不能。

资料也可能充分的反映了真实世界的数据分布,然而,这种数据分布本身就是社会不平等的产物。人工智能需要高质量和有代表性的数据集,以最大限度地负责任地使用人工智能,而好的女权主义人工智能需要好的性别数据。

要解决这个问题,第一步我们可以做的,是让不同身分的人,都能在资料库里得到充分的代表性,让不同性别、种族、地理位置、文化、年龄等身分的人,都能充分的被收录在资料库中。

例如,近年来,巴西的女权主义农业团体一直在推动记录女性农民的生产情况,以彰显女性对巴西经济的贡献。 由于缺乏关于小农生产的按性别分列的数据,以前使妇女的生产能力不为人知,因此被系统地低估了。

另外

第二个问题是关于算法伦理。这些语言资料真实的反映了人类社会的语言使用的状况,也一定程度的真实反映了我们社会中职业分布的确是男医师多于女医师等等情况。这些状况虽然是真实的,但它同时也是社会偏见和不平等的产物。

我们用这种资料去让机器学习,那么我们教导机器去复制我们社会过去对性别、种族、年龄等偏见和不平等,让机器对这些社会上比较弱势的人继续做出不利的判断,让不平等被继续的维持。特别是当我们把这类资料用在关于健康、求职和司法领域的决策时,它有可能让本来已经不易翻身的族群,更长久的留在弱势的位置。

权力差异影响的一个流行例子是国家统计数据。 国家统计数据主要由男性调查员与男性户主交谈收集,往往会低估或歪曲女性的劳动和健康状况。 人工智能系统需要反映这些差距,并计划采取措施来缓解这些差距。

技术对于权力赋予了合理性,掩盖了剥削和压迫的性质。技术性的压迫同时也影响着机器和人的思考方式。

4 我们塑造我们的工具,然后我们的工具塑造我们

马库色Herbert Marcuse并不将技术视为中立的手段,而是一个更加微妙更加复杂的过程。他认为技术不仅影响人们的生活更重要的是影响的人们的思维模式。

使得传统的偏向个人独立思考的个人理性,发展成了一种有机械性思维所支配的技术理性。追求效率的社会让人们依赖科技将科技视为不需要言说的,自明的东西。而人也自然的为了技术会非常自然调整自己的日程和身体。

正如马歇尔·麦克卢汉 (Marshall McLuhan) 所说的那样,“我们塑造我们的工具,然后我们的工具塑造我们”。

和传统的说教式的规训型权力相对,环境管理型权利是不需要和主体有任何交流就可以让主体做出调整一种技术性权力。相比传统的意识形态的背后有个说教的主体,环境权利的背后没有主体,只有一堆机器因此看上去仿佛更加中立。对人类和自然的剥削通过技术理性和消费主义变成了一种合理的东西,而不仅仅是科学背后的意识形态。这是每个人对于所谓技术中立的标签应该反思的。

5 改变,正是时候

女权主义原则可以成为理解和改变人工智能系统影响的便捷框架。 包括反思性、参与性、交叉性和努力实现结构变革。AI 的设计和实施中的反身性意味着对生态系统中涉及的各种利益相关者的特权和权力或缺乏特权和权力的检查。 通过自反,设计人员可以采取措施在设计过程中考虑权力层次结构。

偏见可能是生活中不可避免的事实,但我们不要让它成为新技术不可避免的方面。

新技术让我们有机会重新开始——从人工智能开始——但要消除偏见取决于人,而不是机器。据英国《金融时报》报道,如果不训练人类问题解决者来使 AI 多样化,算法将始终反映出我们自己的偏见。

因此,希望女性与男性一起,在塑造无偏见人工智能世界的未来方面发挥重要而关键的作用。

我们世界的特点是规范不具包容性,并由权力关系维持。

但规范是可以改变的。

今天是妇女节,你正好可以开始尝试一下。

节日快乐。

——Made by Dirty Pomelo. Think that.

Ref:

금희조, 강혜원, 진보래 외 12 저. 2020. 『AI와 더불어 살기』. 서울: 커뮤니케이스 북스. 7장“인공지능 젠더 편향성과 포스트 휴먼 주체,” 8장 “AI와 여성 개발자: 기술산업이 갖는 젠더불평등,” 11장 “AI 알고리즘의 편향과 차별에 대처하는 우리의 자세,” 12장 “AI와 미디어리터러시 이슈 그리고 AI 윤리.”

윤지영. 2018. “디지털 매트릭스의 여성착취문법: 디지털 성폭력의 작동방식과 대항담론.” 『철학연구』 122, 85-134.

김수아 & 장다혜. 2019. “온라인 피해 경험을 통해 본 성적 대상화와 온라인 성폭력 문제.” 『미디어, 젠더& 문화』 34(1), 89-130.

Feminist AI :https://feministai.pubpub.org/

BIOINFO 4 WOMEN :https://bioinfo4women.bsc.es/

“Ex Machina's Hidden Meaning”(8:18):https://www.youtube.com/watch?v=V85VqlVptWM

你好,脏柚子想和你一起学习,思考。创造有活力,友善的知识交流空间。

要一起思考嘛!更多渠道请点击!—— bio.link/dirtypomelo

Hello, Dirty Pomelo wants to study with you. And create a vitality and friendly knowledge space.

Want to be together? Think that! For more Infos!——bio.link/dirtypomelo

Like my work? Don't forget to support and clap, let me know that you are with me on the road of creation. Keep this enthusiasm together!